MiniMax M2: Nový king open-source

Vo svete AI sa veci menia rýchlosťou svetla – alebo aspoň takou rýchlosťou, akou sa trénujú nové modely na desiatkach tisíc GPU.

Rok 2025 bol plný prekvapení. Od Llama 3.1 od Meta až po Qwen 2.5 od Alibaba, konkurencia je tvrdá. Ale príchod MiniMax M2 v októbri 2025 zamiešal karty. Tento čínsky MoE (Mixture-of-Experts) model s 230 miliardami parametrov (z toho len 10 miliárd aktívnych) nie je len ďalší veľký hráč – je to revolúcia v agentických úlohách a kódovaní.

Čo je MiniMax M2?

MiniMax AI, čínska startupová firma zameraná na AGI vydala M2 27. októbra 2025 pod slobodnou MIT licenciou. To znamená, že ho môžete voľne používať, upravovať a dokonca komerčne nasadiť bez obáv z licenčných poplatkov. Model je dostupný na Hugging Face, GitHub a cez API od MiniMaxu (s cenou okolo 0,30 USD za milión vstupných tokenov a 1,20 USD za výstupné – čo je konkurencieschopné).

Čím je M2 taký špeciálny?

Na rozdiel od tradičných "hustých" modelov ako Llama, M2 používa MoE architektúru, kde nie všetky parametre sú aktívne naraz. Z 230B celkových je aktívnych len 10B počas inferencie, čo ho robí neuveriteľne efektívnym. Predstavte si to ako tím expertov: Každý token aktivuje len tých "expertov", ktorí sú na to najvhodnejší. Výsledok? Rýchlejšia odozva, nižšia spotreba energie a možnosť spustiť ho na bežnom hardvéri – napríklad na 4x NVIDIA H100 GPU bez toho, aby ste čakali na superpočítač.

M2 je navrhnutý predovšetkým pre agentické úlohy a kódovanie. To znamená, že exceluje v scenároch, kde AI nie je len pasívny chatbot, ale aktívny "agent", ktorý plánuje, volá nástroje (tool calling), testuje kód, opravuje chyby a dokonca iteruje cez multi-file projekty. Používa tagy ako <think>...</think> pre viditeľné uvažovanie, čo je super užitočné pre debugging. Podporuje nástroje ako web search, API volania alebo príkazovú exekúciu, a je kompatibilný s frameworkmi ako vLLM alebo SGLang pre rýchle nasadenie.

V benchmarkoch? M2 dosahuje skóre 61 bodov v Artificial Analysis Intelligence Index v3.0 (meria inteligenciu cez testy ako MMLU-Pro, GPQA a SWE-bench), čo ho robí č. 1 medzi open-source modelmi – len 7 bodov za hypotetickým GPT-5. V SWE-bench (kódovanie) má 69,4 %, v τ²-Bench (agentické plánovanie) 77,2 % a v GAIA (všeobecné úlohy) 75,7 %. To nie je len teória; reálne testy ukazujú, že M2 zvláda end-to-end workflowy, kde iné modely zlyhajú kvôli veľkým kontextom alebo opakovaným iteráciám.

Ako M2 funguje v praxi?

Príklady z reálneho sveta. Poďme sa pozrieť bližšie na to, čo M2 dokáže. Predstavte si, že ste vývojár v tíme, ktorý buduje webovú appku. Tradičný LLM ako GPT-4o vám napíše kód, ale čo ak treba upraviť 10 súborov naraz, otestovať ho, nájsť regresné chyby a zavolať externé API? M2 to zvládne v jednom cykle:

- Multi-file kódovanie: M2 môže analyzovať celý repozitár, navrhnúť zmeny a dokonca ich aplikovať cez nástroje ako Git.

- Automatizované testovanie: Generuje testy, spustí ich (cez tool calling) a opraví chyby na základe výstupu.

- Agentické cykly: S nízkou latenciou (vďaka MoE) zvláda dlhé interakcie, ako je "browse web, sumarizuj dáta, generuj report".

Napríklad, úloha "Napíš Python skript na analýzu akcií, zavolaj Polygon API a vizualizuj dáta" trvala len sekundy – a výstup bol čistý, s chybovým handlingom.

Pre porovnanie, Llama 3.1 405B by to zvládol, ale s vyššou latenciou a spotrebou pamäte. M2 je aj ideálny pre integrácie. Funguje v IDE ako Cursor alebo VS Code cez rozšírenia, a podporuje voice mode (zatiaľ len v appkách). A áno, je open-source, takže si ho môžete stiahnuť a fine-tunovať na svoje dáta – bezplatne.

Porovnanie s inými open-source LLM: Kto je kráľ?

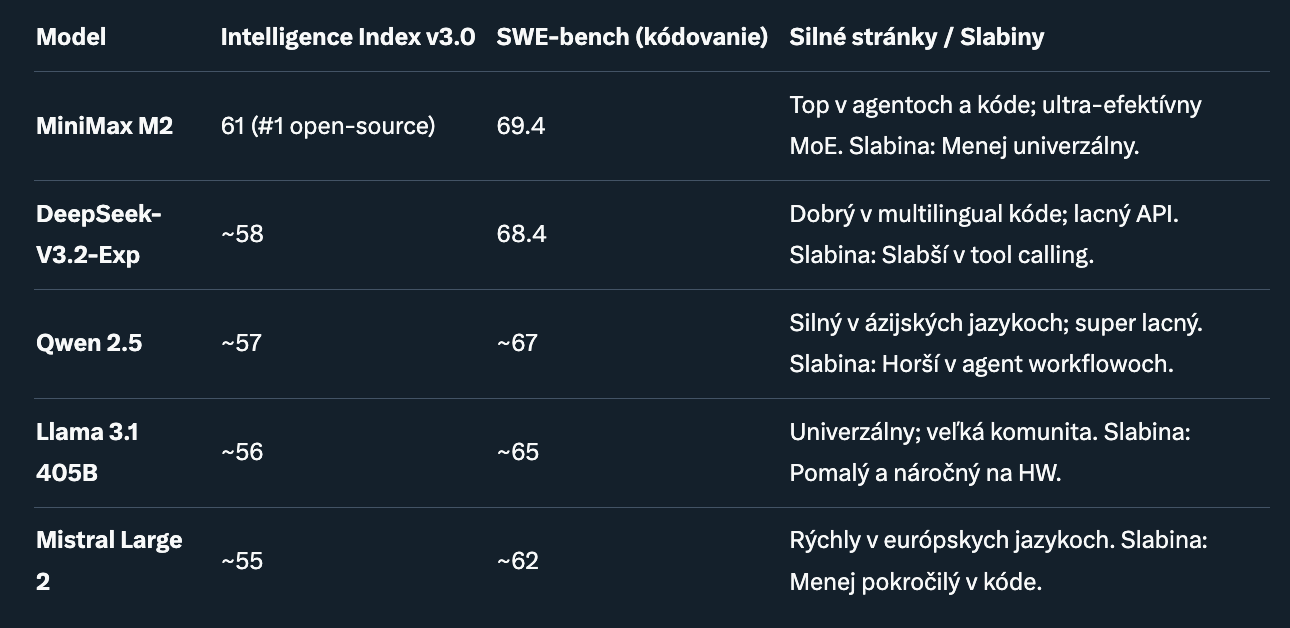

Porovnanie: Výber top open-source modely z roku 2025, vrátane DeepSeek, Qwen, Llama a Mistral. Hodnoty sú z benchmarkov ako SWE-bench, τ²-Bench a Intelligence Index (október–november 2025).

M2 dominuje v agentických úlohách, ale nie je univerzálny vo všetkom.

Z tabuľky jasne vyplýva, že M2 je kráľ v agentoch a kóde, kde prekonáva DeepSeek o 1–2 body v SWE-bench a o 2–3 v τ²-Bench.

- DeepSeek je blízko, najmä v efektivite tréningu (ich DSA attention je geniálna), ale M2 vyhráva v reálnych workflowoch ako BrowseComp (44 % vs. 42 %).

- Qwen je budget-friendly pre multilingual, Llama univerzálny "pracovný kôň", ale M2 je ten, kto mení hru pre autonómne systémy.

Čo ak porovnáme náklady? M2 je drahší na API ako DeepSeek, ale pri lokálnom spustení (cez Ollama) je najefektívnejší – spotrebuje menej VRAMu. Pre malé tímy je to game-changer.

Aplikácie

Kde M2 zažiari? V autonómnych agentoch. Od web scrapingu cez automatizované DevOps po AI asistenta v HR. Predstavte si agenta, ktorý analyzuje GitHub issues, píše PR a merguje ich – M2 to zvládne lepšie ako ktokoľvek iný open-source.

Budúcnosť

MiniMax plánuje M3 v Q1 2026 s podporou vision (obrázky/videá) a ešte väčším kontextom (až 1M tokenov). Komunita rastie. Už sú tu fine-tunes pre špecifické jazyky, vrátane slovenčiny/češtiny cez LoRA.

Tipy na štart:

- Stiahnite z Hugging Face: huggingface.co/MiniMax-AI/M2-230B.

- Spustite lokálne: ollama run minimax-m2.

- Experimentujte s tool calling: Použite LangChain pre integráciu.

- Ak ste na budgete, choďte do DeepSeek; pre agentov – M2.

Prečo by ste mali vyskúšať M2 už dnes

MiniMax M2 nie je len model – je to most k skutočnej AGI v open-source svete. V čase, keď proprietárne modely ako Claude 3.5 Sonnet dominujú, M2 ukazuje, že open-source môže držať krok (a niekedy aj predbehnúť). Ak ste unavení z pomalých, náročných gigantov, M2 je vaša odpoveď. Rýchly, inteligentný a zadarmo. Benchmarky sa môžu meniť; vždy overte na oficiálnych leaderboardoch ako Hugging Face Open LLM Leaderboard.